Ifølge studiet fejler såkaldte ‘simulated reasoning models’ som OpenAI’s o1 og o3, DeepSeek-R1 og Claude 3.7 Sonnet Thinking med at løse problemer, der kræver systematisk tænkning. De producerer resultater, der ikke er bedre end hvis man bare leder efter tidligere svar på problemet i deres træningsdata. Hvilket er, hvad traditionelle store sprogmodeller gør. Studiet, der hedder ‘The illusion of thinking’, kommer frem til en lignende konklusion som en anden nyligt publiceret studie fra USA Mathematical Olympiad.

Forskerne undersøgte såkaldte Large Reasoning Models, der forsøger at simulere en logisk ræsonnerende proces ved at nedbryde komplekse problemer til enklere og løse dem trin for trin.

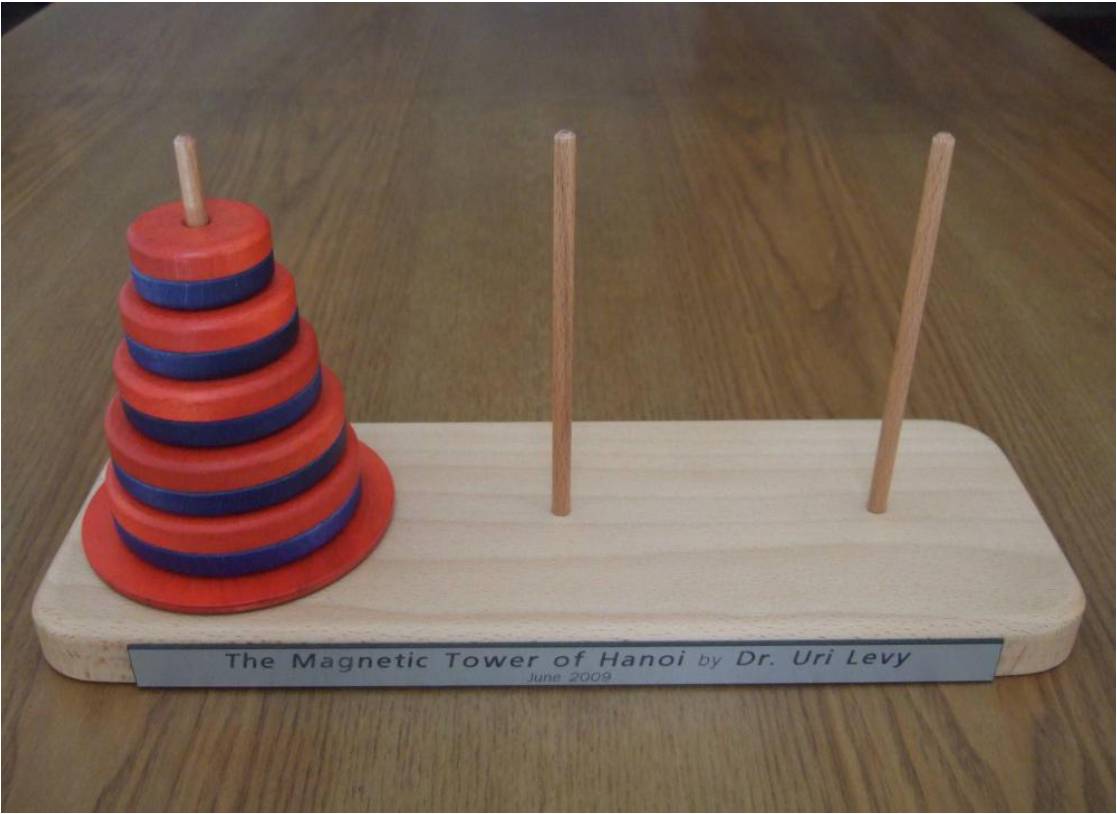

Undersøgelsen bestod i at udsætte AI-modellerne for klassiske tænkeopgaver som Tower of Hanoi, at spille Checkers (dam), tankegåden med at krydse en flod og Blocks World. Man lagde ud på begynderniveau og øgede sværhedsgraden til ekstremt svært. For eksempel kræver et Tower of Hanoi med 20 ringe over en million træk.

Resultatet var, at de kun formåede at vise en løsning i mindre end 5 procent af tilfældene, og kun én formåede at nå op på 25 procent. Ingen af dem lykkedes med at vise en perfekt løsning trods 200 forsøg. Det er på trods af, at AI-forskeren Herb Simon demonstrerede en løsning på Tower of Hanoi tilbage i 1957, og at der findes masser af færdige algoritmer til løsningen online. Selv da forskerne tilføjede algoritmen til modellerne, blev resultaterne ikke bedre. Som en forsker udtrykte det: »Deres proces er ikke logisk og intelligent.«

Forskerne mener, at problemet med de nuværende evalueringer af ræsonneringsmodeller er, at de kun interesserer sig for, om resultatet er korrekt. Det er irrelevant, om svaret fandtes i deres træningsdata, så ingen stiller spørgsmålstegn ved, om de virkelig ræsonnerede sig frem til det eller bare kopierede svaret.

Det skal siges, at undersøgelsen kommer fra Apples forskere, som er den eneste store teknologivirksomhed, der ikke har lanceret sin egen AI-løsning. Den er også blevet kritiseret, da andre forskere påpeger, at nutidens modeller er bygget for ikke at bruge for meget tid på et problem. Hvis de ikke kan løse det hurtigt, så gætter de. Apples forskere siger også selv, at »tankegåder er et snævert felt og måske ikke er repræsentativt for problemløsning generelt«, og advarer mod at ekstrapolere resultaterne og drage for vidtgående konklusioner.

Når det er sagt, blev ChatGPT 4o slået af en Atari 2600-spilkonsol fra 1977, når det gjaldt om at spille skak…

Læs studiet hos Apple Research

Læs videre med LB+

Nyhed! LB+ Total UGE

Fuld adgang til alt LB+ indhold - Ingen bindingsperiode!

TILBUD - 49 kr første måned

Fuld adgang til alt LB+ indhold

LB+ Total 12 måneder

Fuld adgang til alt indhold på Lyd & Billede og L&B Home i 12 måneder

- Adgang til mere end 7.800 produkttests!

- Store rabatter hos vores partnere i LB+ Fordelsklub

- Ugentlige nyhedsbreve med de seneste nyheder

- L&B TechCast – en podcast fra L&B

- Magsinet digitalt – ny udgave hver måned

- Deaktivering af annoncer

- L&B+ Video – kom med L&B-redaktionen bag kulisserne, på de store tech-messer og meget mere!